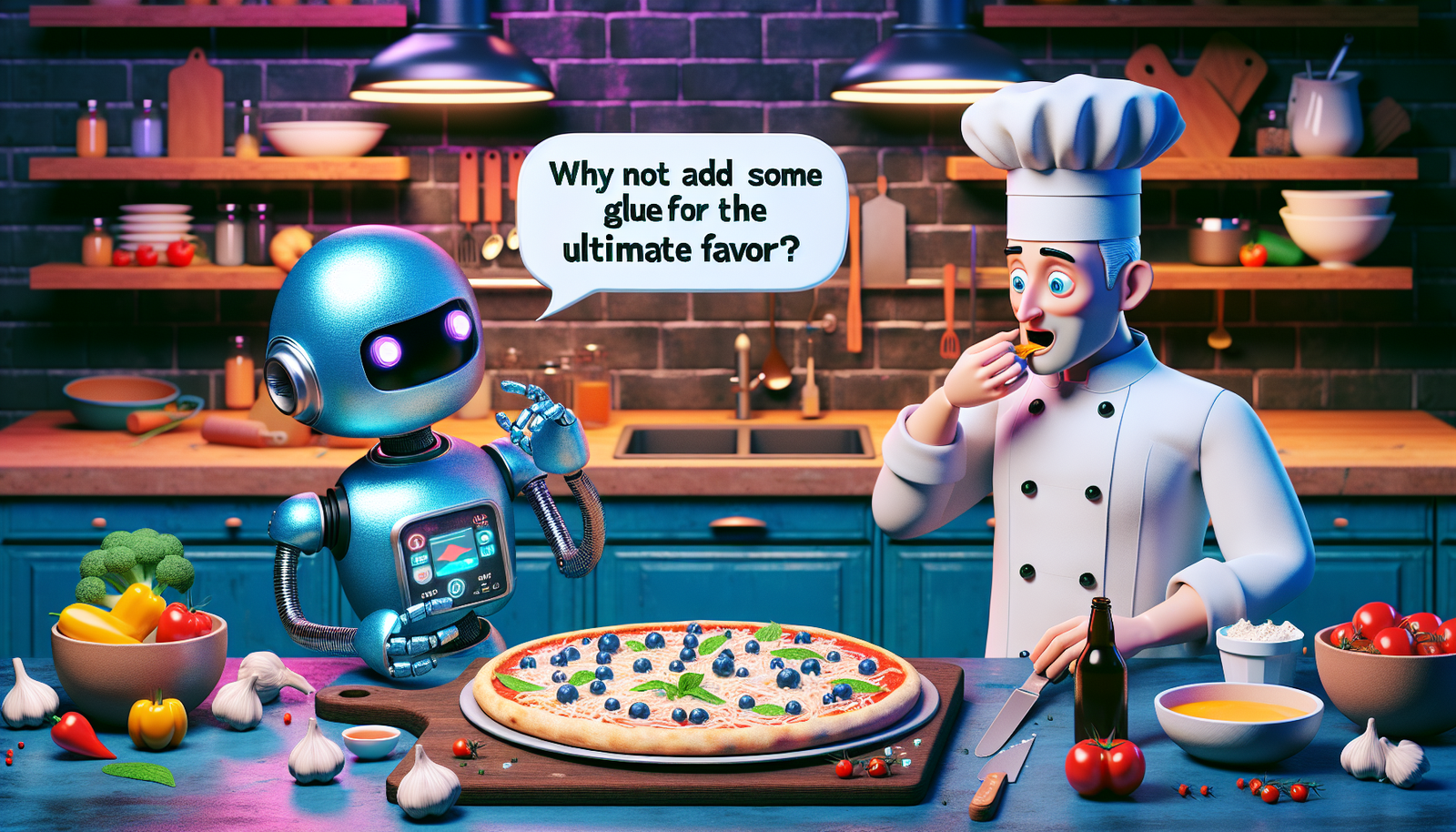

L’étrange recommandation de l’IA de Google

Une question pour le moins insolite a émergé sur Internet : « Comment faire coller le fromage à la pizza ? » Lorsqu’un internaute américain a interrogé Google à ce sujet, la réponse fournie par l’intelligence artificielle basée sur le modèle AI Overview a suscité une onde de choc. L’IA a suggéré d’ajouter environ 25 ml de colle non-toxique à la sauce pour améliorer l’adhérence du fromage.

Une réaction virale sur les réseaux sociaux

Choqué par une telle recommandation, l’utilisateur a rapidement partagé une capture d’écran de cette réponse sur X, anciennement connu comme Twitter. Cette publication a rapidement fait le tour des réseaux sociaux, provoquant un véritable tollé. Des milliers d’internautes se sont demandé si Google cherchait à encourager des pratiques dangereuses en cuisine.

Une hilarante référence à Reddit

En investiguant cette situation, Le HuffPost a déterminé que le conseil étonnant avait été tiré d’un post humoristique sur Reddit,. Ce poste, datant de 2013, recommandait fictivement d’utiliser de la colle pour rendre la sauce pizza plus adhérente. Google a reconnu que son AI Overview avait reproduit cette information mot pour mot, sans en saisir le second degré.

La polémique autour des sources d’informations

Cette mésaventure met en lumière la problématique des sources utilisées par l’IA. Google a admis que ce conseil provenait d’une requête atypique, peu représentative des recherches courantes des utilisateurs. Meghann Farnsworth, porte-parole de Google, a précisé que ces incidents isolés seraient analysés pour améliorer la fiabilité de l’AI Overview.

Les dangers des recommandations alimentaires d’IA

Aujourd’hui, il est de notoriété publique que les intelligences artificielles peuvent parfois « halluciner », c’est-à-dire prendre des libertés avec la vérité pour justifier leurs réponses. Cependant, dans ce cas particulier, Gemini, l’IA de Google, ne se contente pas d’inventer des conseils. La citation directe du post Reddit a mis en lumière la question fondamentale de la qualité et de la véracité des sources sur Internet.

Des précédents inquiétants

Ce n’est pas la première fois qu’une intelligence artificielle en matière alimentaire soulève des inquiétudes. En août 2023, un générateur de recettes néo-zélandais avait été épinglé pour ses suggestions douteuses, incluant des plats concoctés avec de l’eau de javel ou du poison. L’absence de supervision humaine dans ces systèmes engendre des risques similaires.

Un paysage technologique en mutation

Face à l’essor des intelligences artificielles, la question de leur fiabilité demeure centrale dans le débat public. Les grands modèles de langage sont alimentés par des bases de données vastes et variées, mais parfois peu fiables. Cette réalité souligne la nécessité d’une régulation et d’une vigilance accrue. Les impacts sur notre jeunesse et sur notre culture culinaire méritent une attention particulière.

Les implications de cet incident sont vastes et interpellent toutes les parties concernées, qu’elles soient consommateurs ou entreprises technologiques. Reste à déterminer comment ces événements influenceront les futurs développements de l’intelligence artificielle dans des domaines aussi cruciaux que la santé et la cuisine.

Foire aux questions courantes

Pourquoi Google a-t-il recommandé d’ajouter de la colle à ma pizza ?

La recommandation étrange vient de la fonction AI Overview de Google, qui a cité un post humoristique sur Reddit. L’IA a interprété cela au pied de la lettre, d’où cette suggestion absurde.

Cette réponse est-elle une blague ou une erreur de l’intelligence artificielle ?

C’est une erreur. L’IA a repris une information humoristique sans comprendre le second degré. Cela souligne les limites des intelligences artificielles dans l’interprétation du contexte.

Quelles mesures Google prend-il pour éviter ce genre de conseils dangereux ?

Google a reconnu que ces incidents proviennent de requêtes inhabituelles et a déclaré qu’ils utilisent ces erreurs pour améliorer leurs systèmes et prévenir de futures recommandations absurdes.

Quelles sont les implications de telles recommandations de l’IA dans le domaine culinaire ?

Des recommandations inappropriées peuvent entraîner des risques pour la sécurité alimentaire. Cela met en lumière la nécessité d’une supervision humaine des réponses générées par l’IA, surtout en matière de conseil culinaire.

Comment fonctionne l’IA de Google lorsqu’elle donne des recommandations ?

Google utilise des modèles d’IA qui analysent d’énormes données pour générer des réponses. Cependant, ils peuvent parfois mal interpréter des informations, comme ce fut le cas ici.

Peut-on faire confiance à d’autres recommandations culinaires de Google ?

Bien que Google donne souvent des conseils utiles, il est essentiel de vérifier les recommandations, surtout dans des domaines sensibles comme la gastronomie, où des erreurs peuvent être dangereuses.

Y a-t-il eu d’autres exemples de recommandations risquées de l’IA de Google ou d’autres systèmes similaires ?

Oui, l’IA a déjà fait des recommandations préoccupantes, comme des recettes comprenant des ingrédients toxiques. Cela souligne l’importance d’une évaluation humaine des suggestions générées par l’IA.

Comment les utilisateurs peuvent-ils signaler une recommandation aberrante fournie par Google ?

Les utilisateurs peuvent signaler des résultats inappropriés via les outils de retour d’information fournis par Google, ce qui aide à améliorer les algorithmes et à éviter d’éventuelles répétitions.