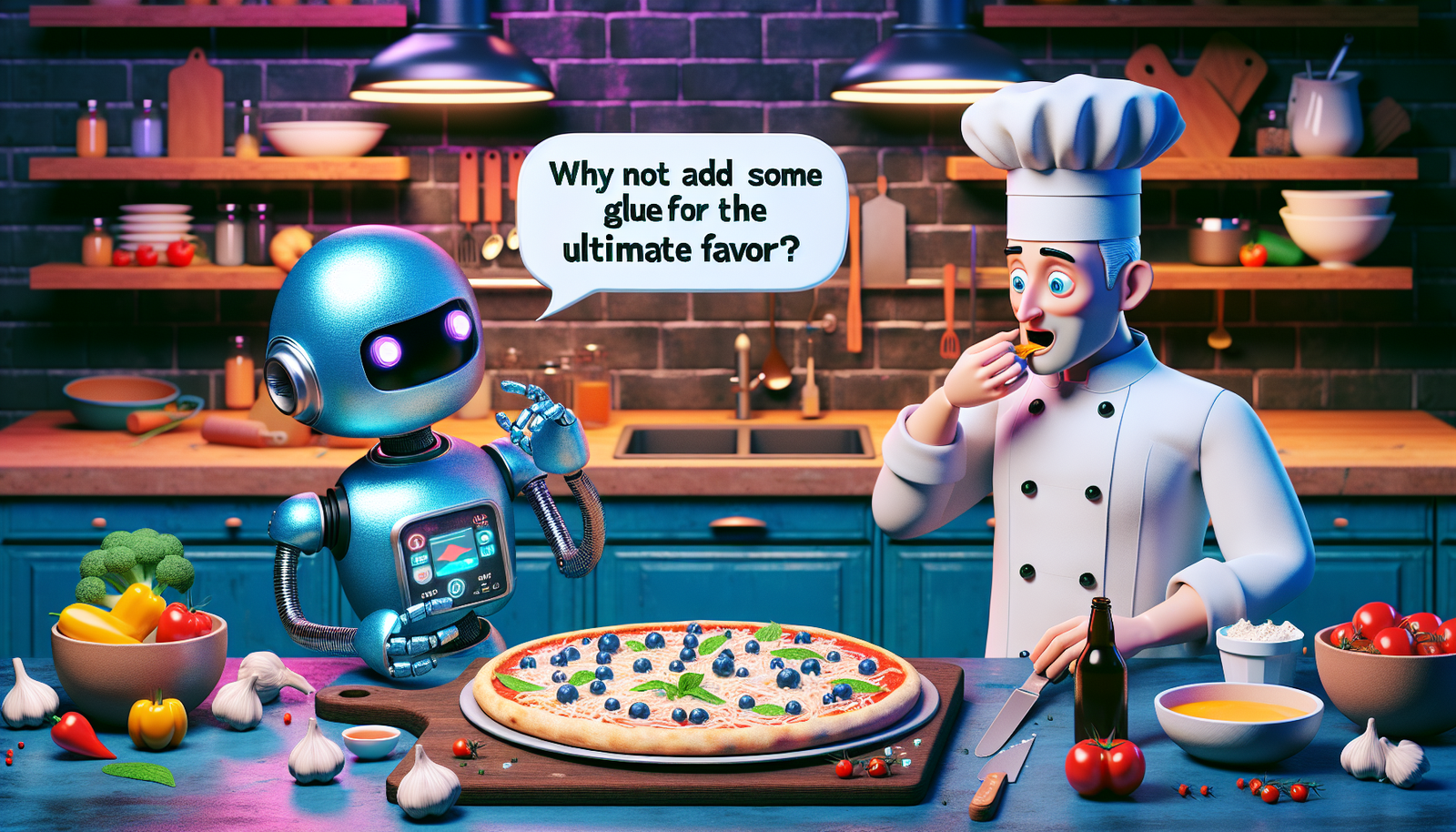

La extraña recomendación de la IA de Google

Una pregunta, por lo menos inusual, ha surgido en Internet: «¿Cómo hacer que el queso se pegue a la pizza?» Cuando un internauta estadounidense preguntó a Google sobre esto, la respuesta proporcionada por la inteligencia artificial basada en el modelo AI Overview causó una ola de choque. La IA sugirió añadir aproximadamente 25 ml de pegamento no tóxico a la salsa para mejorar la adherencia del queso.

Una reacción viral en las redes sociales

Shockado por tal recomendación, el usuario rápidamente compartió una captura de pantalla de esta respuesta en X, anteriormente conocido como Twitter. Esta publicación pronto recorrió las redes sociales, provocando un verdadero escándalo. Miles de internautas se preguntaron si Google estaba tratando de alentar prácticas peligrosas en la cocina.

Una hilarante referencia a Reddit

Investigando esta situación, Le HuffPost determinó que el consejo sorprendente se había extraído de un post humorístico en Reddit. Este post, datado de 2013, recomendaba ficticiamente usar pegamento para hacer que la salsa para la pizza fuera más adherente. Google reconoció que su AI Overview había reproducido esta información palabra por palabra, sin entender el doble sentido.

La polémica en torno a las fuentes de información

Este percance pone de manifiesto el problema de las fuentes utilizadas por la IA. Google admitió que este consejo provenía de una consulta atípica, poco representativa de las búsquedas comunes de los usuarios. Meghann Farnsworth, portavoz de Google, precisó que estos incidentes aislados serían analizados para mejorar la fiabilidad del AI Overview.

Los peligros de las recomendaciones alimentarias de la IA

Hoy en día, es de conocimiento público que las inteligencias artificiales pueden a veces «alucinar», es decir, tomar libertades con la verdad para justificar sus respuestas. Sin embargo, en este caso particular, Gemini, la IA de Google, no solo se limita a inventar consejos. La cita directa del post de Reddit ha puesto de relieve la pregunta fundamental sobre la calidad y veracidad de las fuentes en Internet.

Precedentes inquietantes

No es la primera vez que una inteligencia artificial en el ámbito alimentario genera preocupaciones. En agosto de 2023, un generador de recetas de Nueva Zelanda fue criticado por sus sugerencias dudosas, incluyendo platillos elaborados con lejía o veneno. La falta de supervisión humana en estos sistemas crea riesgos similares.

Un paisaje tecnológico en cambio

Frente al auge de las inteligencias artificiales, la cuestión de su fiabilidad sigue siendo central en el debate público. Los grandes modelos de lenguaje son alimentados por bases de datos vastas y variadas, pero a veces poco fiables. Esta realidad subraya la necesidad de regulación y vigilancia. Los impactos en nuestra juventud y en nuestra cultura culinaria merecen una atención particular.

Las implicaciones de este incidente son vastas y afectan a todas las partes involucradas, sean consumidores o empresas tecnológicas. Queda por determinar cómo estos eventos influirán en los futuros desarrollos de la inteligencia artificial en áreas tan cruciales como la salud y la cocina.

Preguntas frecuentes

¿Por qué Google recomendó añadir pegamento a mi pizza?

La extraña recomendación proviene de la función AI Overview de Google, que citó un post humorístico de Reddit. La IA lo interpretó al pie de la letra, de ahí esta absurda sugerencia.

¿Es esta respuesta una broma o un error de la inteligencia artificial?

Es un error. La IA tomó información humorística sin entender el doble sentido. Esto subraya los límites de las inteligencias artificiales en la interpretación del contexto.

¿Qué medidas está tomando Google para evitar este tipo de consejos peligrosos?

Google ha reconocido que estos incidentes provienen de consultas inusuales y ha declarado que están utilizando estos errores para mejorar sus sistemas y prevenir futuras recomendaciones absurdas.

¿Cuáles son las implicaciones de tales recomendaciones de la IA en el ámbito culinario?

Recomendaciones inapropiadas pueden generar riesgos para la seguridad alimentaria. Esto pone de manifiesto la necesidad de supervisión humana en las respuestas generadas por la IA, especialmente en lo relacionado con el consejo culinario.

¿Cómo funciona la IA de Google al dar recomendaciones?

Google utiliza modelos de IA que analizan enormes datos para generar respuestas. Sin embargo, a veces pueden malinterpretar información, como fue el caso aquí.

¿Se puede confiar en otras recomendaciones culinarias de Google?

Aunque Google a menudo ofrece consejos útiles, es esencial verificar las recomendaciones, especialmente en áreas sensibles como la gastronomía, donde los errores pueden ser peligrosos.

¿Ha habido otros ejemplos de recomendaciones riesgosas de la IA de Google u otros sistemas similares?

Sí, la IA ya ha hecho recomendaciones preocupantes, como recetas que incluyen ingredientes tóxicos. Esto subraya la importancia de una evaluación humana de las sugerencias generadas por la IA.

¿Cómo pueden los usuarios reportar una recomendación aberrante proporcionada por Google?

Los usuarios pueden reportar resultados inapropiados a través de las herramientas de retroalimentación proporcionadas por Google, lo que ayuda a mejorar los algoritmos y evitar futuras repeticiones.