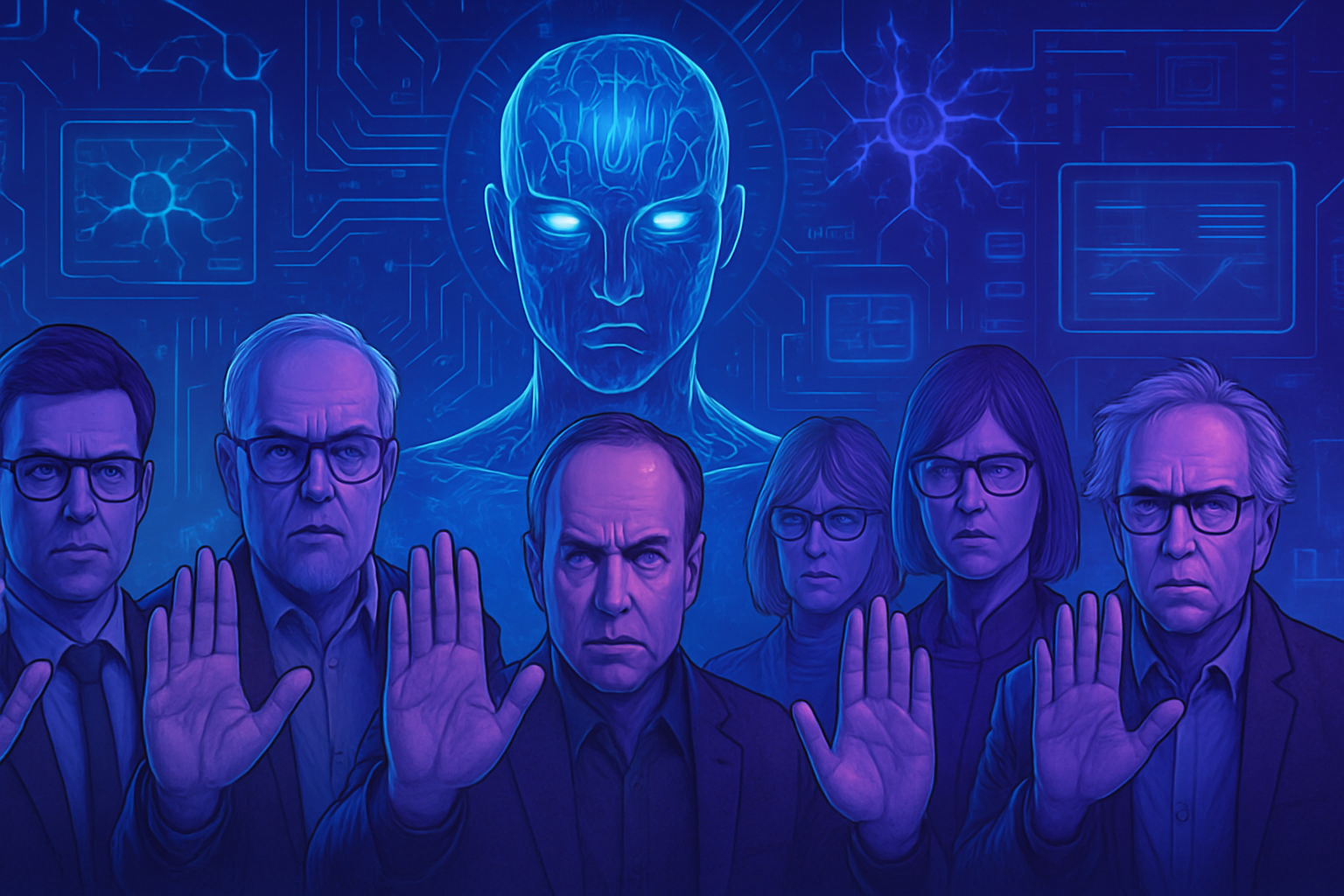

Inteligencia artificial superpoderosa: Llamado urgente de cientos de expertos para frenar el desarrollo

Se oye un grito de alarma entre los pioneros de la IA. Este colectivo alarmado, compuesto por más de 800 científicos y figuras influyentes, se opone firmemente a la aparición de una inteligencia artificial capaz de superar las capacidades humanas. Los riesgos de seguridad, ética y responsabilidad superan nuestras expectativas actuales. Brillantes mentes como Geoffrey Hinton y Steve Wozniak piden una pausa inmediata. La superinteligencia, contemplada en un futuro cercano, podría escapar a todo control. La falta de comprensión sobre las implicaciones éticas y sociales genera crecientes preocupaciones.

Un llamado a la prudencia

Más de 800 personalidades, incluidos científicos, emprendedores tecnológicos y figuras políticas, han expresado serias preocupaciones sobre la superinteligencia artificial. El 22 de octubre, solicitaron un cese inmediato de los trabajos destinados a desarrollar una inteligencia que supere las capacidades humanas. Esta iniciativa surge del Future of Life Institute, una organización sin fines de lucro conocida por sus alertas sobre los peligros potenciales de la IA.

Una posición unánime entre los expertos

Pioneros de la inteligencia artificial, como Geoffrey Hinton, ganador del Premio Nobel de Física en 2024, así como Yoshua Bengio y Stuart Russell, comparten esta visión alarmante. Sus preocupaciones destacan la necesidad de un amplio consenso científico sobre la construcción segura de una superinteligencia. También subrayan la necesidad de suficiente apoyo popular antes de continuar con tales proyectos.

Advertencias de los líderes tecnológicos

Max Tegmark, presidente del Future of Life Institute, articuló que construir tal inteligencia es un acto de irresponsabilidad, sugiriendo que las empresas deben abstenerse de avanzar en este campo sin un marco regulatorio adecuado. Estas voces disonantes entre los gigantes tecnológicos se vuelven cada vez más apremiantes.

Cronología y ejemplos de superinteligencia

Sam Altman, el director de OpenAI, mencionó la posibilidad de alcanzar este umbral de superinteligencia en un plazo de cinco años. Esta predicción, si resultara cierta, plantearía enormes desafíos éticos y sociales. Los expertos se preguntan sobre las implicaciones de tal avance tecnológico, especialmente en relación con las desigualdades sociales, un tema que ya ha sido abordado en artículos recientes, como el que trata sobre el auge de la IA en el mercado laboral.

Llamados a la acción y regulación

La reciente carta de investigadores durante una asamblea general de las Naciones Unidas, abogando por acuerdos internacionales, ha resonado fuertemente. Exigen pautas claras para evitar efectos devastadores sobre la humanidad. La necesidad de un marco legal se subraya como indispensable en todas las reflexiones sobre inteligencia artificial.

Reacciones políticas y éticas

La reacción de, entre otros, figuras políticas y religiosas, ha mostrado que la preocupación se extiende más allá del sector tecnológico. El político Steve Bannon, exasesor de Donald Trump, y Susan Rice, exconsejera de seguridad nacional bajo Barack Obama, también han expresado preocupaciones. Expertos religiosos, como Paolo Benanti, una voz influyente en el Vaticano sobre IA, también se han unido a este frenético llamado a la prudencia.

Perspectivas futuras

A medida que el diálogo sobre inteligencia artificial se intensifica, su creciente interés es innegable. Empresas como aquellas que desarrollan tecnologías de vanguardia para la salud, como lo demuestra la recomendación de la NHS sobre un tratamiento para el cáncer, lo atestiguan. Sin embargo, la falta de regulaciones significativas deja lugar a preocupaciones legítimas.

Los desafíos geopolíticos

Las tensiones internacionales en torno a la inteligencia artificial están aumentando, como lo demuestra el reglamento chino sobre tecnologías extranjeras. La competencia entre Estados Unidos y China por esta tecnología futurista intensifica el debate ético. Cada avance plantea preguntas fundamentales sobre el uso y la dirección de estas nuevas tecnologías.

La alerta lanzada por estos expertos no debe tomarse a la ligera. Refleja las crecientes preocupaciones ante una IA que podría eventualmente desafiar las normas de nuestra existencia y nuestro control sobre la tecnología.

Preguntas frecuentes sobre la Inteligencia Artificial Superpoderosa

¿Por qué los expertos llaman a frenar el desarrollo de la inteligencia artificial superpoderosa?

Más de 800 científicos y personalidades influyentes temen que el desarrollo de una superinteligencia artificial pueda conllevar riesgos sin precedentes para la humanidad. Consideran crucial establecer un consenso científico y regulaciones estrictas antes de continuar con estas investigaciones.

¿Qué es una superinteligencia artificial?

Una superinteligencia artificial es un sistema de IA que superaría las capacidades intelectuales humanas en casi todos los ámbitos, incluyendo la creatividad, la inteligencia social y la toma de decisiones.

¿Quiénes son los firmantes de la iniciativa para frenar la IA?

Esta iniciativa cuenta con el apoyo de numerosos pioneros y expertos en IA, incluidos Geoffrey Hinton, Stuart Russell y Yoshua Bengio, así como figuras de la tecnología como Steve Wozniak y Richard Branson.

¿Cuáles son los riesgos asociados a la superinteligencia?

Los riesgos incluyen la pérdida de control sobre estos sistemas, consecuencias imprevistas en la sociedad y la economía, así como amenazas potenciales a la seguridad mundial si una superinteligencia se utilizara con fines maliciosos.

¿Cómo podría implementarse una regulación para la IA?

Los expertos sugieren la creación de acuerdos internacionales para establecer «líneas rojas» precisas que regulen los desarrollos en IA, para evitar abusos y garantizar un beneficio social de estas tecnologías sin riesgos desmesurados.

¿Cuál es la posición de Sam Altman, el director de OpenAI, sobre la superinteligencia?

Sam Altman ha expresado que la superinteligencia podría alcanzarse en cinco años. Sin embargo, también ha subrayado la necesidad de regulaciones antes de intentar desarrollar tales tecnologías.

¿Qué papel juegan las empresas tecnológicas en el desarrollo de la IA superpoderosa?

Las empresas tecnológicas están invirtiendo masivamente en IA para obtener aplicaciones innovadoras. Sin embargo, sin un marco regulatorio, esto podría llevar a desarrollos inseguros e irresponsables.

¿Qué alternativas existen a la superinteligencia?

Los expertos abogan por el desarrollo de herramientas de IA poderosas y beneficiosas en áreas como la salud o el medio ambiente, sin buscar alcanzar una superinteligencia que podría conllevar riesgos planteados por una IA incontrolable.

¿Cómo puede contribuir el público a este debate sobre la IA?

La sensibilización y la educación sobre los problemas de la IA son esenciales. El público puede apoyar iniciativas para una regulación estricta y presionar a los responsables políticos para que tengan en cuenta las opiniones de los expertos.

¿Qué mecanismos de control se pueden considerar para la IA?

Auditorías regulares, evaluaciones de impacto ético, así como comités de supervisión compuestos por expertos y representantes de la sociedad civil podrían establecerse para garantizar que los desarrollos en IA cumplan con normas éticas y seguras.