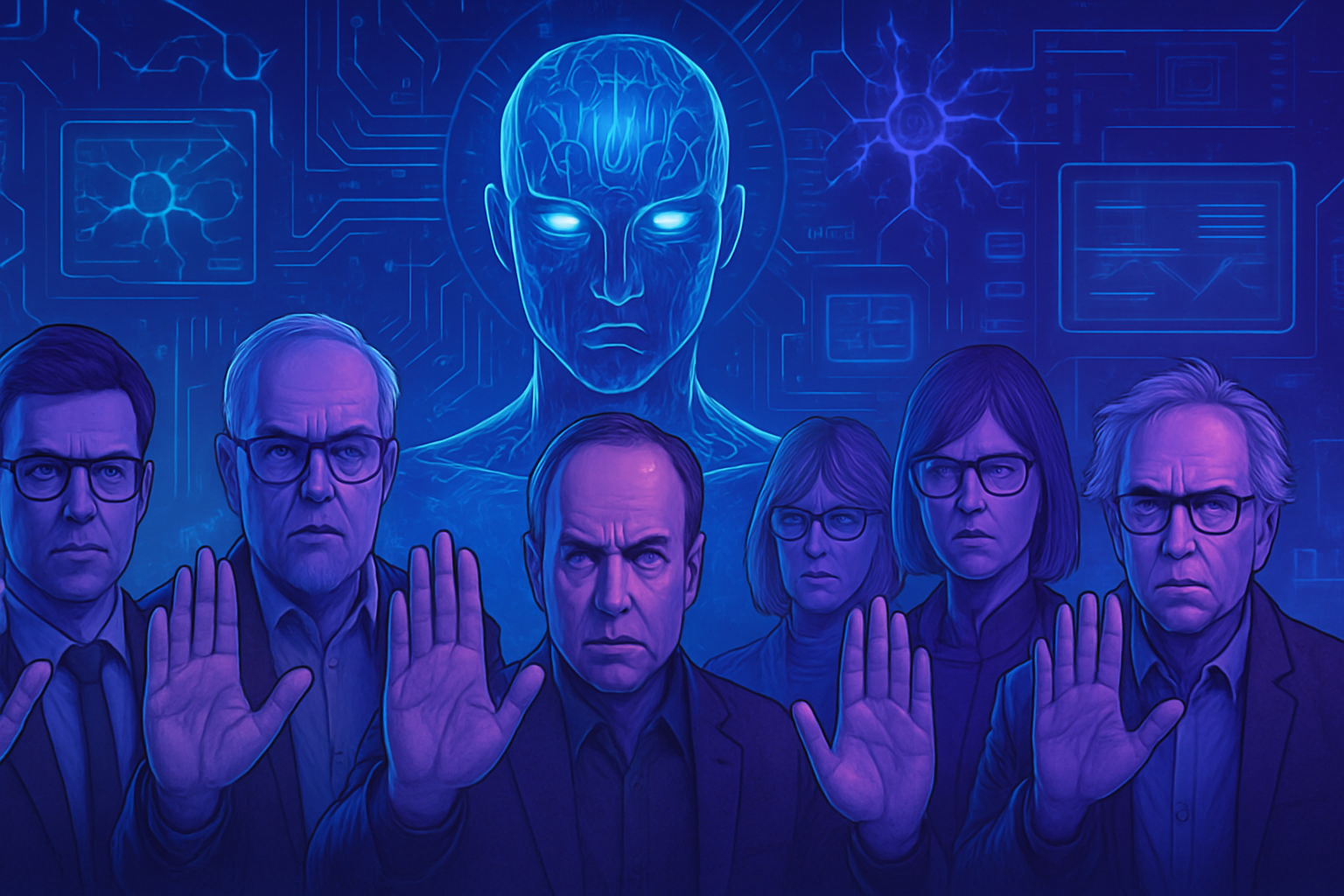

超強人工智能:數百名專家的緊急呼籲,要求放慢開發

在人工智能的先驅中響起警報聲。 這個由超過800名科學家和影響力人物組成的集體,堅決反對出現能超越人類能力的人工智能。安全、倫理和責任的問題超出了我們現在的預期。 像Geoffrey Hinton和Steve Wozniak這樣的傑出人才,呼籲立即暫停。 計劃在不久的將來出現的超智能可能會失控。 對倫理和社會影響的缺乏理解引發了日益嚴重的擔憂。

呼籲謹慎

超過800位人士,包括科學家、科技企業家和政治人物,對人工智能超智能表達了強烈的擔憂。在10月22日,他們呼籲立即停止開發能超越人類能力的智能的工作。這項倡議出自未來生命研究所,這是一個以警告人工智能潛在危險而聞名的非營利組織。

專家之間的共識

人工智能的先驅,如2024年諾貝爾物理學獎得主Geoffrey Hinton,以及Yoshua Bengio和Stuart Russell,均分享這一警惕的視角。他們的擔憂凸顯了在建設超智能方面應當達成廣泛科學共識的必要性。他們還強調,在推進這樣的項目前,需要足夠的公眾支持。

科技領袖的警告

未來生命研究所的主席Max Tegmark表示,建造這樣的智能是一種不負責任的行為,建議企業在沒有合適的監管框架的情況下,應該停止在這個領域的前進。這些科技巨頭中日益增多的異議聲音越發迫切。

超智能的時間表與範例

OpenAI的首席執行官Sam Altman提到在五年內達到超智能的可能性。如果這一預測準確,那將給倫理和社會帶來巨大挑戰。專家們對這種技術進步的含義提出質疑,包括社會不平等問題,這一話題在最近的文章中也有所提及,例如討論人工智能在勞動市場上的崛起。

行動和監管的呼籲

研究人員在聯合國大會上的最新信函,呼籲簽署國際協議,引起了強烈反響。他們要求制定明確的指導方針,以避免對人類造成災難性的影響。在所有關於人工智能的討論中,對法律框架的需求被強調為不可或缺。

政治和倫理的反應

政治和宗教人物的反應,顯示出擔憂超出了科技界。政治人物Steve Bannon,曾任Donald Trump的顧問,以及Susan Rice,前Barack Obama的國安顧問,也表達了關切。宗教專家,如在梵蒂岡有影響力的AI專家Paolo Benanti,也加入了這一急迫的謹慎呼籲。

未來展望

隨著人工智能的對話愈發激烈,其日益增長的關注是不可否認的。企業,如開發前沿健康技術的公司,顯然是證據,像NHS對癌症治療的建議所示。然而,缺乏實質性的監管使人們感到合理的擔憂。

地緣政治問題

圍繞人工智能的國際緊張局勢日益加劇,這從中國對外國技術的限制中可以看出。美國與中國之間對這種未來技術的競爭使倫理辯論愈發激烈。每一次進步都提出了關於這些新技術使用和指向的根本問題。

專家的警告不容小覷。它反映了對人工智能可能最終挑戰我們存在標準和對科技的控制的日益關注。

超強人工智能的常見問題

為什麼專家呼籲放慢超強人工智能的開發?

超過800名科學家和影響力人物擔心,開發一種超智能人工智能可能會對人類帶來前所未有的風險。他們認為在繼續這些研究之前,建立科學共識和嚴格的監管是至關重要的。

什麼是超智能人工智能?

超智能人工智能是一種在幾乎所有領域,包括創造力、社交智力和決策能力方面超越人類智力的AI系統。

減緩人工智能倡議的簽署人是誰?

這一倡議得到了眾多AI先驅和專家的支持,包括Geoffrey Hinton、Stuart Russell和Yoshua Bengio,以及像Steve Wozniak和Richard Branson這樣的科技人物。

與超智能相關的風險是什麼?

風險包括對這些系統失去控制、對社會和經濟造成未預見的後果,以及如果超智能被用於惡意目的則可能對全球安全造成威脅。

如何為人工智能建立監管?

專家建議建立國際協定,以便制定明確的“紅線”,規範人工智能的發展,以避免濫用並確保這些技術的社會效益無過度風險。

OpenAI的首席執行官Sam Altman對超智能的立場是什麼?

Sam Altman表示,超智能可能在五年內達成。然而,他也強調在試圖開發這些技術之前需要監管。

科技公司在超強人工智能開發中扮演什麼角色?

科技公司在人工智能上投入巨資以開發創新應用。然而,沒有監管框架,這可能會導致不安全和不負責任的開發。

超智能有什麼替代選項?

專家呼籲在健康或環境等領域開發強大且有益的AI工具,而不是追求可能引發無法控制的AI風險的超智能。

大眾如何能為這場人工智能的討論作出貢獻?

對人工智能問題的認知和教育至關重要。大眾可以支持有關嚴格監管的倡議,並向政策決策者施壓,要求考慮專家的意見。

對人工智能可以考慮哪些控制機制?

可以設立定期審計、倫理影響評估,以及由專家和公民社會代表組成的監察委員會,以確保人工智能的發展遵循倫理和安全的標準。