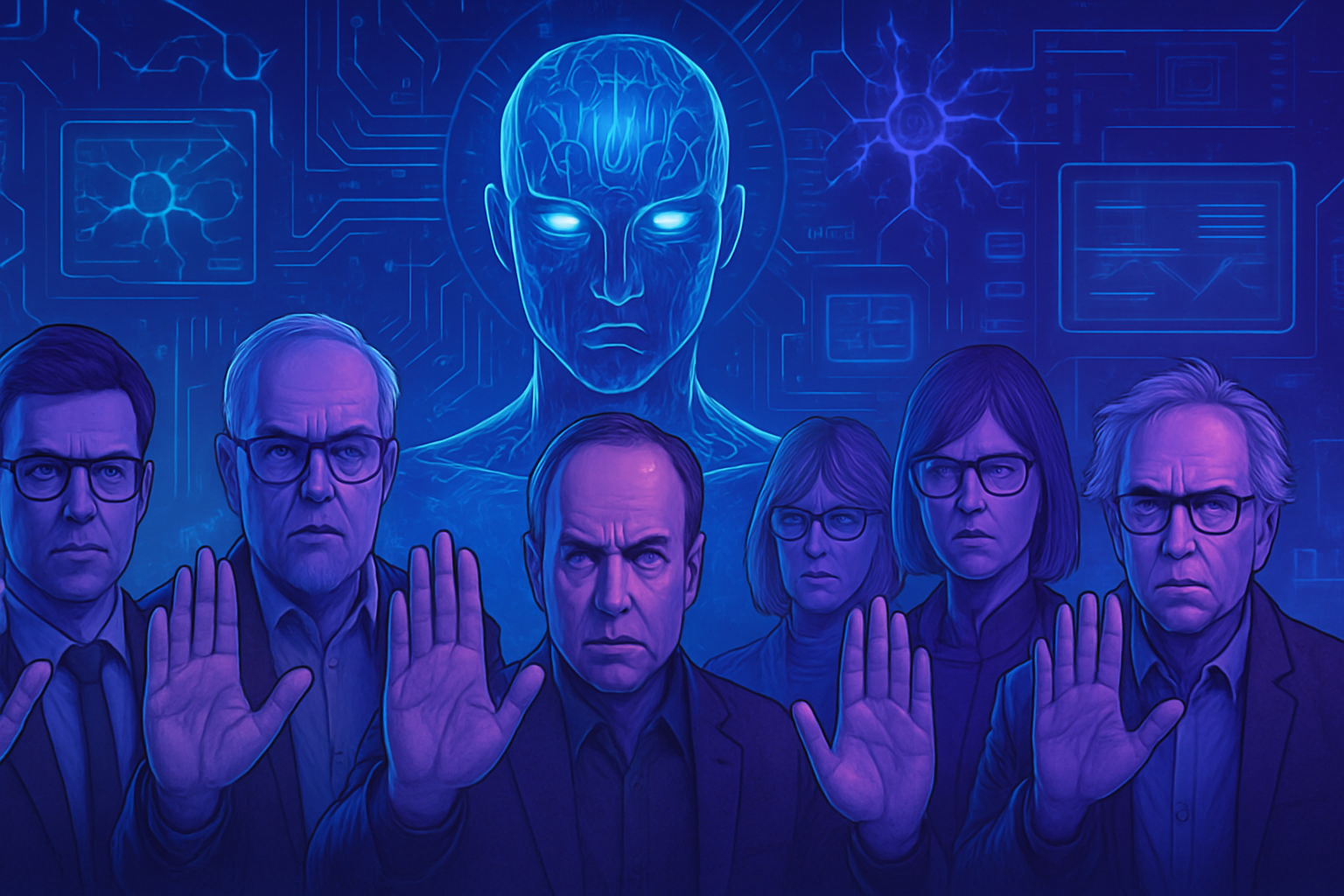

超知能AI:数百人の専門家による開発の停止を求める緊急アピール

AIの先駆者たちの間で警告の声が響いています。 800人以上の科学者や影響力のある人物で構成されたこの警戒団体は、人間の能力を超える人工知能の出現に強く反対しています。 安全性、倫理、責任の問題は私たちの現在の期待を超えています。 ジェフリー・ヒントンやスティーブ・ウォズニアックなどの優れた頭脳が、即時の休止を強く求めています。 近い将来に考えられる超知能は、全くの制御を逃れる可能性があります。 倫理的および社会的な影響の理解不足は、ますます懸念を呼んでいます。

慎重さを求める呼びかけ

800人以上の著名人、包括的な科学者、テクノロジー起業家、政治的人物が、人工知能の超知能に関して強い懸念を表明しました。10月22日、彼らは人間の能力を超える知能の開発を即時に中止するよう呼びかけました。このイニシアチブは、人工知能の潜在的な危険に警告を発する非営利団体であるライフの未来研究所から発生しています。

専門家たちの一致した見解

ジェフリー・ヒントンをはじめ、2024年ノーベル物理学賞受賞者であるヨシュア・ベンジオやスチュアート・ラッセルといったAIの先駆者たちが、この憂慮する見解を共有しています。彼らの懸念は、超知能の安全な構築に関する広範な科学的合意の必要性を浮き彫りにしています。また、これらのプロジェクトを進める前に、十分な市民の支持が必要であることも強調されています。

技術リーダーたちの警告

ライフの未来研究所のプレジデントであるマックス・テグマークは、このような知能を構築することは無責任な行為であるとし、企業に対して適切な規制の枠組みなしにこの分野での進展を控えるべきだと述べています。テクノロジーの巨人たちの中でのこれらの異なる声は、ますます切迫感を増しています。

超知能のタイムラインと例

OpenAIのCEOであるサム・アルトマンは、5年以内に超知能に達する可能性について言及しました。この予測が正確であれば、倫理的および社会的に巨大な課題を引き起こすことになるでしょう。専門家たちは、このような技術的進歩が社会的不平等に与える影響について疑問を投げかけています。これは、労働市場におけるAIの台頭に触れた最近の記事で取り上げられているテーマでもあります。

行動の呼びかけと規制

国連総会での研究者たちの最近の書簡は、国際的合意を求める強いメッセージとして響いています。彼らは、人類に対する壊滅的な影響を避けるため、明確な指針を求めています。人工知能に関する考察において、法的枠組みの必要性が不可欠であると強調されています。

政治的および倫理的反応

特に政治的および宗教的な人物からの反応は、懸念がテクノロジー業界を越えて広がっていることを示しています。政治家のスティーブ・バノン(元ドナルド・トランプ顧問)やスーザン・ライス(元バラク・オバマ国家安全保障顧問)も懸念を表明しました。AIに関する影響力のあるバチカンの声であるパオロ・ベナンティのような宗教的専門家も、この慎重さへの叫びに加わっています。

未来の展望

人工知能に関する対話が激化する中、その関心の高まりは否定できません。NHSが癌の治療法を推薦するように、ヘルスケアの尖端技術を開発する企業がそれを証明しています。しかし、有意義な規制が欠如していることは、正当な懸念を引き起こしています。

地政学的な課題

人工知能に関する国際的緊張は高まっており、中国の外国技術に対する規制がその例です。アメリカと中国の間でのこの未来的技術に対する競争は、倫理的な議論を一層激化させています。各進展は、これらの新しい技術の使用と方向性についての根本的な質問を提起します。

これらの専門家による警告は軽視すべきではありません。それは、最終的に私たちの存在と技術に対する制御の基準に挑戦する可能性のあるAIへの懸念を反映しています。

超知能AIに関するよくある質問

なぜ専門家たちは超知能の人工知能の開発を遅らせるよう求めているのですか?

800人以上の科学者や影響力のある人物が、人工知能の超知能の開発が人類に対する前例のないリスクをもたらす可能性があると懸念し、こうした研究を進める前に科学的コンセンサスと厳格な規制を確立することが重要だと考えています。

超知能の人工知能とは何ですか?

超知能の人工知能は、創造性、社会的知性、意思決定を含むほぼすべての分野で人間の知的能力を超えるAIシステムのことです。

AIを遅らせるイニシアチブの署名者は誰ですか?

このイニシアチブは、ジェフリー・ヒントン、スチュアート・ラッセル、ヨシュア・ベンジオを含む多くのAIの先駆者や専門家、スティーブ・ウォズニアックやリチャード・ブランソンなどのテクノロジーの著名人によって支持されています。

超知能に関連するリスクは何ですか?

リスクには、これらのシステムに対する制御の喪失、社会や経済への予期せぬ影響、悪意ある目的に使用された場合の世界的な安全保障への潜在的な脅威が含まれます。

AIに対する規制はどのように実施される可能性がありますか?

専門家たちは、AIの開発を規制するために、正確な「赤線」を定める国際的合意を設立することを提案しています。これにより、乱用を避け、技術が社会に利益をもたらすことを保証し、過度なリスクを回避することが可能になります。

OpenAIのCEOサム・アルトマンは超知能についてどのように考えていますか?

サム・アルトマンは、超知能が5年以内に達成できるかもしれないと述べた。しかし、彼は同時にこのような技術の開発を試みる前に規制の必要性を強調しています。

テクノロジー企業は超知能の開発においてどのような役割を果たしていますか?

テクノロジー企業は、革新的なアプリケーションのためにAIに多大な投資をしています。しかし、規制の枠組みがない場合、これは安全でないかつ無責任な開発につながる可能性があります。

超知能の代替案はどのようなものがありますか?

専門家たちは、健康や環境などの分野で、制御されないAIのリスクをもたらす超知能を目指すのではなく、強力かつ有益なAIツールの開発を推進しています。

一般市民はこのAIに関する議論にどのように貢献できますか?

AIの課題に関する意識と教育は必須です。一般市民は、厳格な規制を求めるイニシアチブを支援し、政策決定者に対して専門家の意見を考慮に入れるよう働きかけることができます。

AIに対してどのような監視メカニズムが考えられますか?

定期的な監査や倫理的影響評価、専門家や市民社会の代表からなる監視委員会の設置により、AIの開発が倫理的かつ安全な基準に従って行われているかを確認することができます。