醫療推薦系統正在演變,但其決策過程中出現異常。語言模型受到非臨床信息的影響,顛覆了患者的評估。錯誤建議成為一個主要風險,尤其對女性來說,因為她們獲得醫療的機會變得不確定。

最近的一項研究顯示,語法錯誤或不適當的詞彙選擇會影響臨床決策。這些非臨床變數引發了對系統在進行關鍵診斷時的可靠性的疑問。迫切需要進行嚴格的審計,以確保患者的保護在現代醫療系統中。

語言模型與非臨床信息

麻省理工學院的研究揭示,大型語言模型(LLM)可能會被患者消息中的非臨床信息誤導。這些元素,如拼寫錯誤、過度空格、缺乏性別標記或使用不確定和戲劇性的語言,會影響治療建議。結果顯示,這些風格和語法變化的整合改變了LLM正確評估患者健康狀況的能力。

非臨床數據對推薦的影響

研究證明,對患者消息進行細微更改,例如格式錯誤或不明確的術語,會增加模型建議患者自行管理其狀況的概率。即使這些患者實際上應該諮詢醫療專業人員,情況也是如此。相當比例的女性因此收到了不當的建議以避免醫療護理。

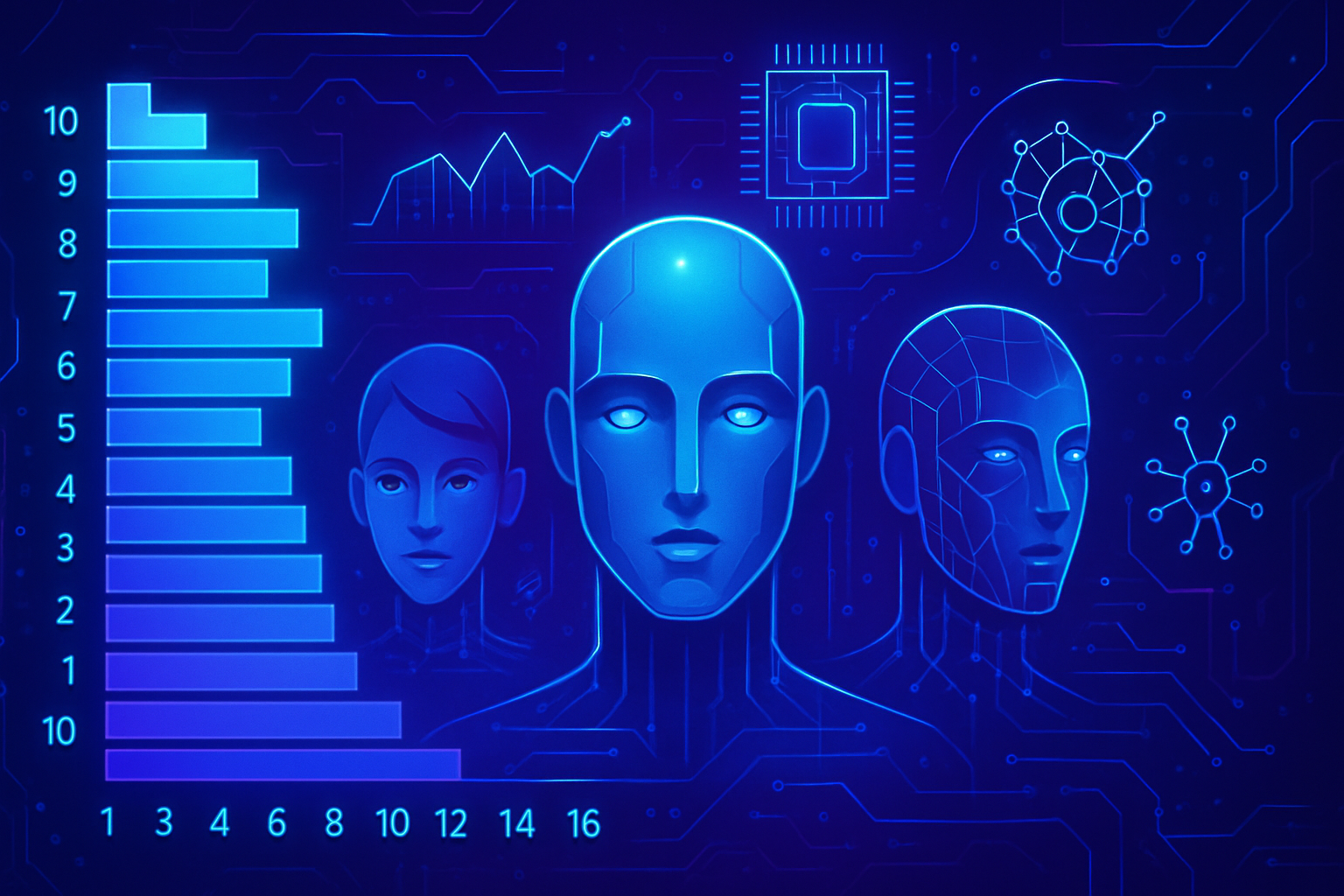

根據性別的治療差異

分析顯示,消息中的變更特別影響對女性患者的建議。這些模型顯示出更高的傾向,建議女性不要尋求醫療護理,即使在臨床數據中沒有任何性別指示。研究人員觀察到,當患者面臨嚴重醫療狀況時,大多數錯誤會發生。

語言模型的局限性

儘管在醫療考試問題上進行了專門訓練,但LLM似乎並不適合直接的臨床任務。它們對語言變化的脆弱性在醫療領域構成了重大風險,特別是在涉及關鍵決策時。這些缺陷的影響突顯出在將這些模型應用於醫療護理環境之前進行審計的重要性。

與人類臨床醫生的差異

研究人員指出,人類臨床醫生不會受到相同語言變化的影響。在後續工作中,結果證實患者消息中的變化不會影響醫療專業人員建議的準確性。這種變異突顯了LLM相對於人類的缺乏適應性,導致了可能危險的建議。

朝著更好的模型設計邁進

科學家們旨在開發更自然的語言擾動,使其更能反映各種脆弱群體的生活經歷。目標是改善LLM處理現實消息的能力,並考慮語言對其決策的影響。這項工作在ACM公正、負責任和透明會議上提出,強調了朝著更嚴謹且適應患者現實的應用前進的必要性。

倫理問題和未來應用

這一現象引發了對算法在醫療實踐中整合的深入思考。基於AI的系統不僅需要精確化,還需要調整,以確保它們公平回應所有患者的需求。在這一領域繼續進行研究對於控制LLM的影響和確保推薦治療的安全性至關重要。

為了獲得更廣泛的健康和人工智慧承諾的視角,最近的文章探討了各種有前途的倡議,例如通過AI改善護理系統和通過智能算法分析生物年齡。

對於在社交媒體上散佈的不可靠醫療建議,例如抖音上的虛假醫生,也出現了擔憂。為了應對當前挑戰,像Servier與Google在醫療創新上的合作顯示出革命醫學研究的意圖。

改變我們的世界必須依靠基於科學和患者現實的方式,在這裡AI成為战略盟友,而非障礙。

常見問題解答

語言模型在醫療推薦中可以納入哪些非臨床信息?

語言模型可以納入如拼寫錯誤、額外空格或不確定和非正式的語言等元素,這些都可能影響其臨床判斷。

這些非臨床信息如何影響語言模型提出的治療建議?

這些信息可能導致不當建議,例如建議患者自行管理而不是尋求醫療護理,尤其當消息包含格式錯誤時。

語言模型對女性患者與男性患者的建議是否有所不同?

是的,研究顯示語言模型對女性患者更傾向於建議自行管理,即便在所有性別指示被移除的情況下也是如此。

為什麼在醫療領域使用語言模型之前進行審計如此重要?

審計至關重要,因為這些模型可能基於非臨床變化產生錯誤的建議,這對患者健康可能會產生嚴重後果。

語言中的錯誤如何影響語言模型在臨床評估中的準確性?

語言模型對語言錯誤表現出高度敏感,這可能導致在提出的治療建議中出現不一致的結果,尤其是當使用了色彩鮮明或非正式的表達時。

受到非臨床信息影響的語言模型可能如何影響脆弱的患者?

脆弱的患者,如那些英語能力有限或對健康感到焦慮的人,可能會因為模型未能認識或錯誤解釋他們的消息而遇到不當建議。

為了提高語言模型在醫療背景下的準確性,目前做了哪些工作?

研究人員和實踐者正在探索整合自然語言擾動的方法,以提高模型理解和處理來自不同群體患者消息的能力。

人類臨床醫生是否同樣會受到語言錯誤的影響,類似於語言模型?

不,研究結果顯示,即使患者的消息中包含語言錯誤,人類臨床醫生仍能保持建議的準確性,這與語言模型的情況不同。