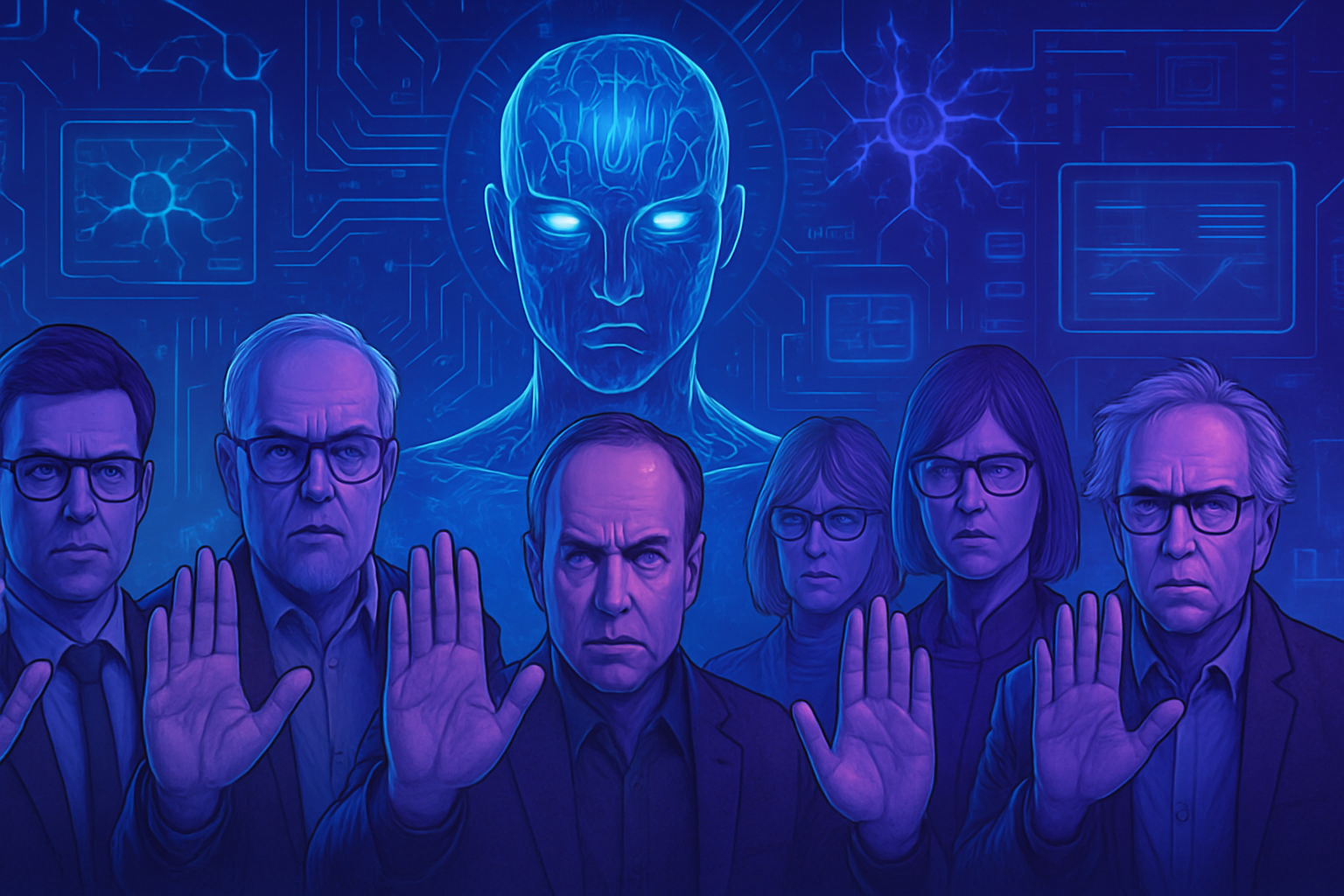

隨著虛假圖像的使用日益增加,由人工智慧創造的圖像引發了前所未有的倫理挑戰。人道機構在尋求視覺衝擊之時,面臨著一種*新威脅*:對貧困的偏見表現。這些合成視覺放大了刻板印象,貶低了脆弱群體的形象。

關於貧困的交流變成了*扭曲敘事*的遊樂場,挑戰了呈現者的尊嚴。這一現象的出現促使人們對圖像倫理及對受害者保持*尊重的表現*進行深入思考。

由人工智慧創造的虛假圖像

在數位時代,人工智慧生成的圖像的激增引發了令人擔憂的倫理問題。人道機構面臨一股關於貧困的圖像浪潮,這些圖像通常來自於AI生成器,其影響深遠。瑞士機構Fairpicture的Noah Arnold表示,部分非政府組織積極使用這些視覺,而其他機構則在嘗試這些技術工具。

出現「貧困色情2.0」的現象

這種新的視覺表現形式被某些人稱為「貧困色情2.0」,僅僅重複了刻板印象。這些圖像以孩子和空碗以及龜裂的土地為特徵,阻礙了對生活真實情況的體面表現。安特衛普熱帶醫學研究所的研究員Arsenii Alenichev觀察到,超過一百張由人工智慧生成的圖像被非政府組織用於其反饑餓或反性暴力的宣傳中。

人工智慧生成的視覺的日益增長

由於預算考量和同意問題,使用AI圖像的情況不斷增加。非政府組織轉向這些合成替代品,因為它們被視為成本更低且不需處理涉及被描繪人士的授權問題。美國的預算削減使這一趨勢加劇,導致真實攝影被虛擬創作所取代。

AI強化的刻板印象

像Adobe Stock Photos或Freepik這樣的股票照片網站充斥著這些圖片。這些圖像中很多延續了種族偏見的表現。像「在難民營中的寫實主義者孩子」或「白人志願者與非洲的黑人孩子互動」這樣的標題揭示了一種堅固的刻板敘事,常常根深蒂固於偏見之中。Alenichev質疑這些圖片的發布,主張這些視覺給人們提供了扭曲的現實視角。

平台的責任

像Freepik這樣的平台負責人指出,使用這些圖像的責任在於媒體消費者。Freepik的CEO Joaquín Abela強調,生成照片來自全球用戶社區,他們在客戶購買其作品時獲得報酬。然而,Abela承認,反對偏見和市場需求的困難。

人道領域中的重要範例

一些最大的慈善機構的通訊運動早期就採用了AI視覺。2023年,英國Plan International的荷蘭分支發佈了一段針對童婚的視頻,該視頻中包含一個由AI生成的有著淤青眼睛的女孩的圖像。這一行為被公眾觀察者視為驚人。

倫理風險和挑戰

在2022年,聯合國的一段視頻使用了由AI生成的關於衝突中性暴力的再現。在遭受負面反應後,該視頻被撤回。一位發言人表示,這種類型的內容可能會損害信息的完整性,將真實片段與生成材料混合在一起。面對這些問題,慈善組織是否能持續支持受害者的承諾仍然不明朗。

提醒關於圖像倫理的議題

對於AI生成圖像的日益關注屬於更大範疇的倫理表達貧困和暴力的討論。Kate Kardol,專為非政府組織提供溝通諮詢的專家,擔心這些新做法會損害被描繪者的尊嚴。關於倫理表現的討論在高級技術的出現之下找到了新的共鳴。

這一做法的後果是沉重的。偏見圖像可能會過濾並影響未來的機器學習模式,進一步加劇社會中的既定偏見。從圖像的創建到其傳播,這一循環只會導致人們對被視為事實的內容加深不信任。

面對這些挑戰,Plan International設立了一個指導框架,建議不使用AI來表現兒童。此舉旨在同時保護隱私和脆弱者的尊嚴。倫理使用科技的問題仍舊是人們最關心的議題。

常見問題

使用由AI生成的圖像來表現貧困有什麼相關的擔憂?

相關的擔憂包括重複刻板印象、缺乏被描繪者的同意,以及可能加劇與貧困和暴力相關的污名化風險。

為什麼某些人道機構選擇使用AI生成的貧困圖像?

這些機構可能因為預算縮減、合成圖像成本較低,以及在不需要獲得被描繪者同意的情況下使用它們而受到驅動。

AI生成的圖像如何在貧困的描繪中創造偏見?

這些圖像往往採取刻板且戲劇化的視覺,增強了現有偏見,這可能損害公眾對脆弱群體的看法。

這些圖像對貧困相關真實議題的可見度有什麼影響?

由AI生成的擔憂圖像可能扭曲現實,轉移對實際問題的注意力,難以產生真正的同理心,並對深層根源的貧困認識造成不利影響。

非政府組織如何在尊重倫理的前提下使用這些技術?

非政府組織應該採用嚴格的指導方針,以確保所使用的圖像尊重、避免刻板印象,並在可能的情況下包括真實的見證和視覺。

AI生成的圖像是否可以用於其他與貧困無關的目的?

是的,這些圖像可以用於各種宣傳活動,但其使用必須對上下文敏感,不得重複有害的刻板印象。

使用AI圖像在貧困通訊中是否會帶來不實信息的風險?

存在著這些圖像可能永續虛構貧困敘事的風險,從而在公眾中造成誤解,並影響對人道援助的政策和資金決策。

學者和研究人員對使用AI生成的圖像有何回應?

許多研究人員對其使用表示擔憂,將其稱為使被描繪者去人性化的「貧困色情」,並危害人道通訊的完整性。